Ollama¶

简介¶

Ollama 是一个本地运行的 LLM(大语言模型)管理工具,允许用户在本地设备上下载、运行和微调各种开源大模型,如 LLaMA、Mistral 和 Gemma,而无需依赖云端计算资源。

安装环境¶

序号 |

集群 |

平台 |

版本 |

位置 |

安装方式 |

|---|---|---|---|---|---|

1 |

hpckapok1 |

gpu |

ollama 0.6.2 |

/share/software/ollama/ |

安装包 |

使用方法¶

hpckapok1¶

1、申请节点

salloc -N 1 -n 9 -p gpuA800 --gres=gpu:1 -t 120:00

2、登录节点

ssh -Y 计算节点

3、指定models位置(默认/share/software/ollama/models,需要自己指定可用export OLLAMA_MODELS=~/models:$OLLAMA_MODELS),然后加载ollama服务,

module load ollama/0.6.2

nohup ollama serve &

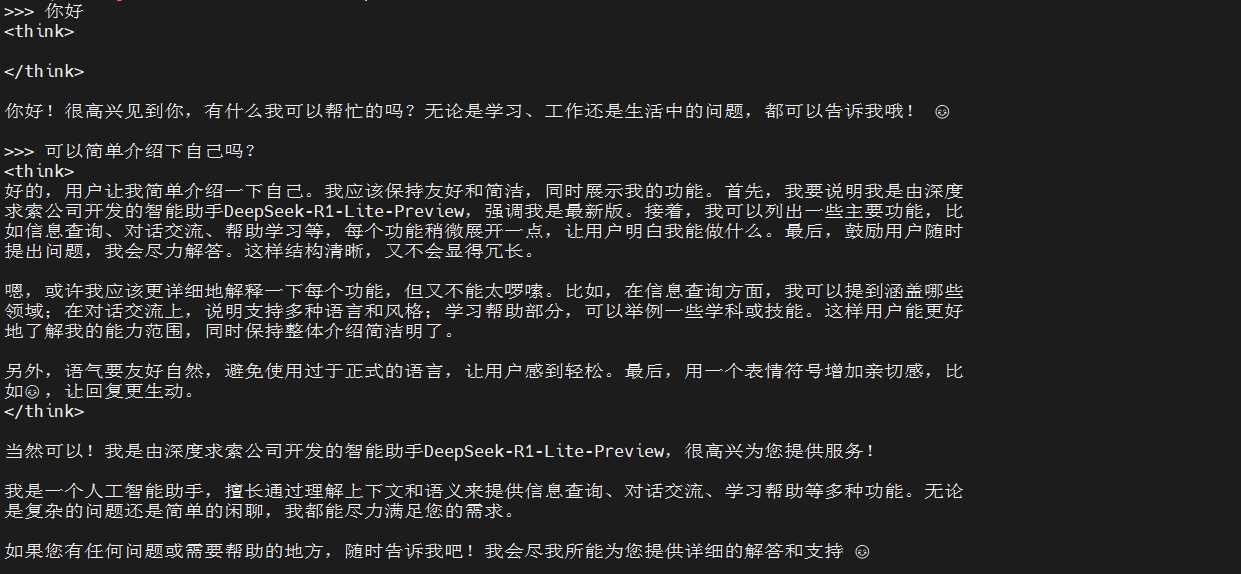

4、查看并用ollama加载deepseek模型

ollama list #查看可用模型

ollama run deepseek-r1:32b #加载模型

5、开始大模型对话

作业提交¶

1、创建作业脚本ollama.sh

#!/bin/bash

#SBATCH --job-name=deepseek

#SBATCH --partition=gpuA800

#SBATCH --ntasks-per-node=9

#SBATCH --gres=gpu:1

#SBATCH --time=06:00:00

#SBATCH --output=output.log

#SBATCH --error=error.log

module load anaconda/3-2023.09

source activare your_env #激活自己的虚拟环境

module load ollama/0.6.2 #默认models文件位置/share/software/ollama/models

# export OLLAMA_MODELS=~/models #指定自己的models文件路径

nohub ollama serve & #打开ollama服务

python your_ollama_script.py

2、提交作业

sbatch ollama.sh

参考资料¶

1、自定义模型下载

Contributor:qbxie

最后更新:

2026 年 01 月 15 日